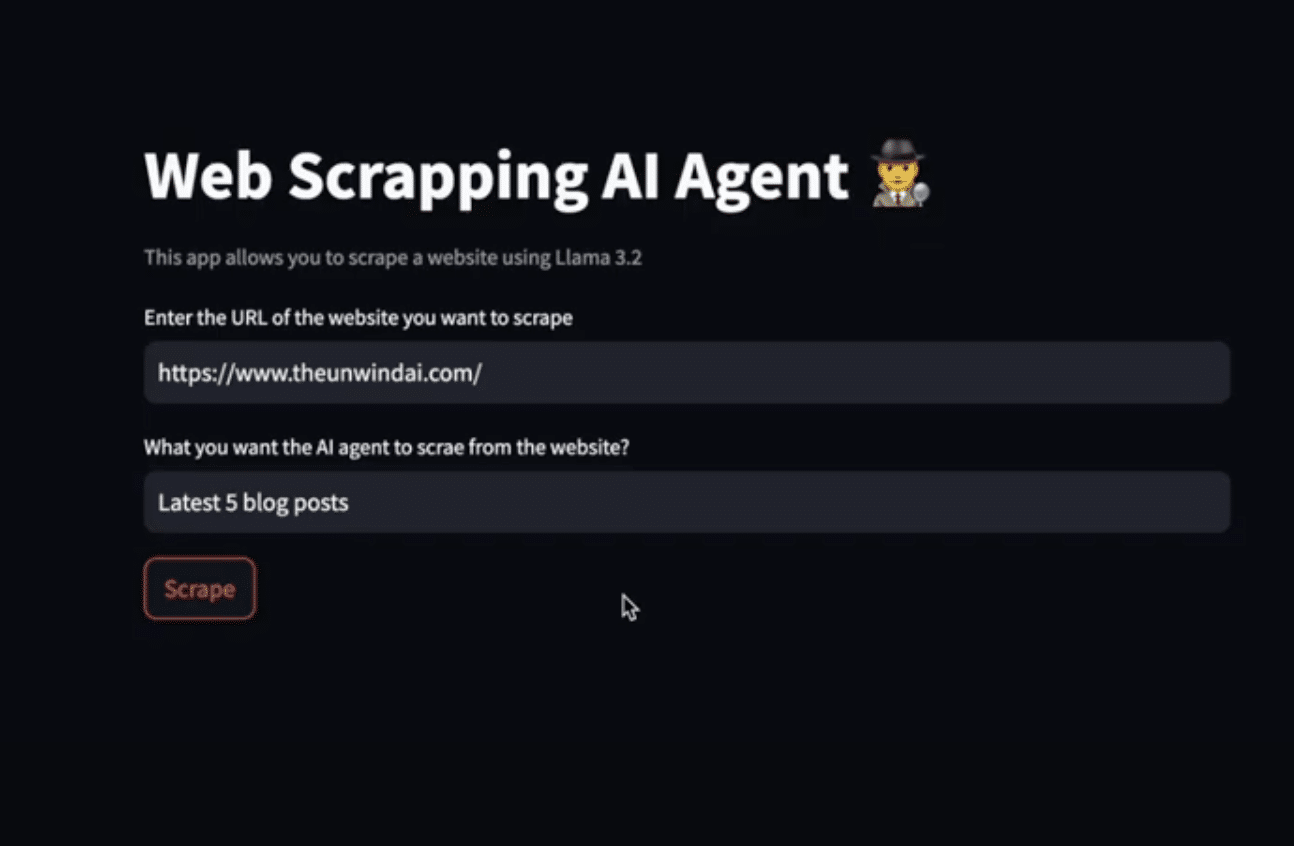

本地部署的智能网页采集助手:基于 Llama 3.2 的构建指南

本文将指导你如何在本地环境中构建一个智能网页采集助手,利用 Llama 3.2 模型,实现无需联网即可高效抓取网页数据。

🧰 所需工具与环境准备

Python 3.7+:确保已安装。

Ollama:用于本地运行 Llama 3.2 模型。

ScrapeGraphAI:结合 LLM 和图结构逻辑的网页采集库。

Streamlit:快速构建交互式网页应用的框架。

代码编辑器:推荐使用 VS Code 或 PyCharm。

🛠️ 构建步骤概览

克隆项目仓库:

git clone https://github.com/Shubhamsaboo/awesome-llm-apps.git

cd web_scrapping_ai_agent安装依赖:

pip install -r requirements.txt确保 Ollama 正在运行:

Ollama 应该在本地的 11434 端口运行。

创建 Streamlit 应用:

新建 local_ai_scrapper.py 文件,并添加以下代码:

import streamlit as st

from scrapegraphai.graphs import SmartScraperGraph

st.title("网页采集智能助手")

st.caption("使用 Llama 3.2 模型进行网页数据抓取")

url = st.text_input("请输入要采集的网页 URL")

user_prompt = st.text_input("请输入采集指令(例如:提取所有标题)")

graph_config = {

"llm": {

"model": "ollama/llama3.2",

"temperature": 0,

"format": "json",

"base_url": "http://localhost:11434",

},

"embeddings": {

"model": "ollama/nomic-embed-text",

"base_url": "http://localhost:11434",

},

"verbose": True,

}

if st.button("开始采集"):

smart_scraper_graph = SmartScraperGraph(

prompt=user_prompt,

source=url,

config=graph_config

)

result = smart_scraper_graph.run()

st.write(result)运行应用:

streamlit run local_ai_scrapper.py🎯 应用亮点

本地运行:无需依赖外部服务,数据处理更安全。

智能采集:通过自然语言指令,灵活定义采集内容。

快速部署:不到 40 行代码,即可实现完整功能。

通过上述步骤,你可以快速构建一个本地运行的智能网页采集助手,提升数据获取的效率和灵活性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...