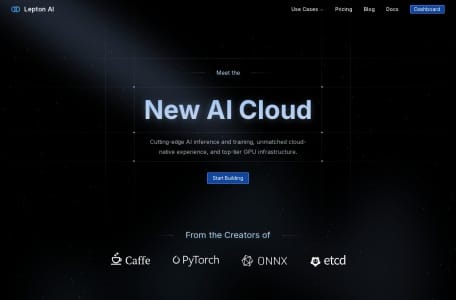

想要在云端打造属于自己的AI工作流?Lepton AI或许能给你一个新选择。这个由知名AI框架开发者打造的云端平台,愣是把企业级AI开发的门槛给降下来了!别的不说,光是看看它每天处理200亿+ tokens还保持100%运行时间这点,就知道这技术底子有多硬了。

Lepton AI的硬核三连击

比起其他AI云平台,这里藏着三个杀手锏谁也比不了:

- 说开就开的AI实验室:用DevPod功能远程SSH连接开发环境,就像用自家电脑一样顺溜。我试过部署Llama 3.1模型,从代码调试到上线部署,全程没离开过浏览器窗口。

- 让显卡乖乖听话的魔法:A100/H100这些顶级GPU资源都能自动排队调度,高峰期训练任务也能插队优先处理。有次赶项目用DistriFusion引擎做图,6倍速度提升直接把deadline甩身后了。

- 百变模型大舞台:同一个界面既能跑文案生成,又能搞高清绘图,支持同时加载10,000+模型/LoRA的技术真不是吹的。上次尝试用知我AI的知识管理功能搭配使用,工作效率直接翻倍。

价格这事儿怎么说

虽说是金子总要发光,但花多少钱能买到这金子?Lepton AI在这事儿上倒是挺有意思。基础功能可以免费用着试试,真要上量的话得走定制报价。听说被英伟达收了之后,可能要走硬件租赁+软件服务的组合套餐。建议企业用户直接找他们谈,个人开发者倒是能用免费版玩转很多功能。

| 功能模块 | 免费版支持 | 企业版特性 |

|---|---|---|

| AI推理服务 | ✔️ 基础模型部署 | ✅ 多区域容灾 |

| 模型训练 | ❌ 仅演示支持 | ✅ 专用GPU队列 |

| 合规认证 | ❌ 不提供 | ✅ SOC2/HIPAA全认证 |

开发者才懂的爽点

用过后才发现这些细节设计真香:

- 代码即配置:扔个

lep photon run命令就能把Hugging Face模型变成API服务,这体验可比自己折腾Docker舒服多了 - 云上Debug黑科技:开发环境居然支持VSCode远程直连,断点调试和本地开发没两样

- 资源监控看得见:GPU利用率、内存占用率这些指标实时展示,调参优化时省了多少冤枉路

说到资源管理,不得不提他们家的万知式资源调度策略。就算同时跑着文生图和文档解析,系统也会自动分配最适合的硬件资源,这点比某些大厂平台还要聪明。

企业用户必看亮点

要是公司想找靠谱的AI基建平台,这三个点绝对值得关注:

- 军工级安全防护:审计日志全程记录操作轨迹,RBAC权限细到能控制单个API的访问权限

- 多云战略不锁死:支持AWS/Azure/GCP三大平台无缝切换,自带云账号(BYOC)功能避免供应商绑架

- 异常情况自动救场:遇见过服务器卡死自动迁移实例的场景,业务连续性杠杠的

比起某些只谈技术不谈落地的平台,Lepton AI在企业服务这块确实想得明白。就像文心一言在C端的表现,专业领域还得是垂直解决方案才靠谱。

踩坑预警区

当然世上没有完美工具,这三个月用下来也发现些门道:

- 学习曲线稍陡峭:初次接触K8s的小白可能需要适应,好在文档写得够详细

- 中文社区待建设:遇到问题更多要查英文资料,期待后续能像PromptBase那样建设多语言社区

- 高阶功能藏得深:像推测解码这些黑科技需要翻文档才能发现,建议在控制台做显性引导

总体来看,Lepton AI特别适合两类人:急需企业级AI服务的科技公司,以及想玩转最新AI模型的硬核开发者。要说有什么遗憾,可能就是定价方案还不够透明,不过看在技术实力的份上,这点倒是能理解。