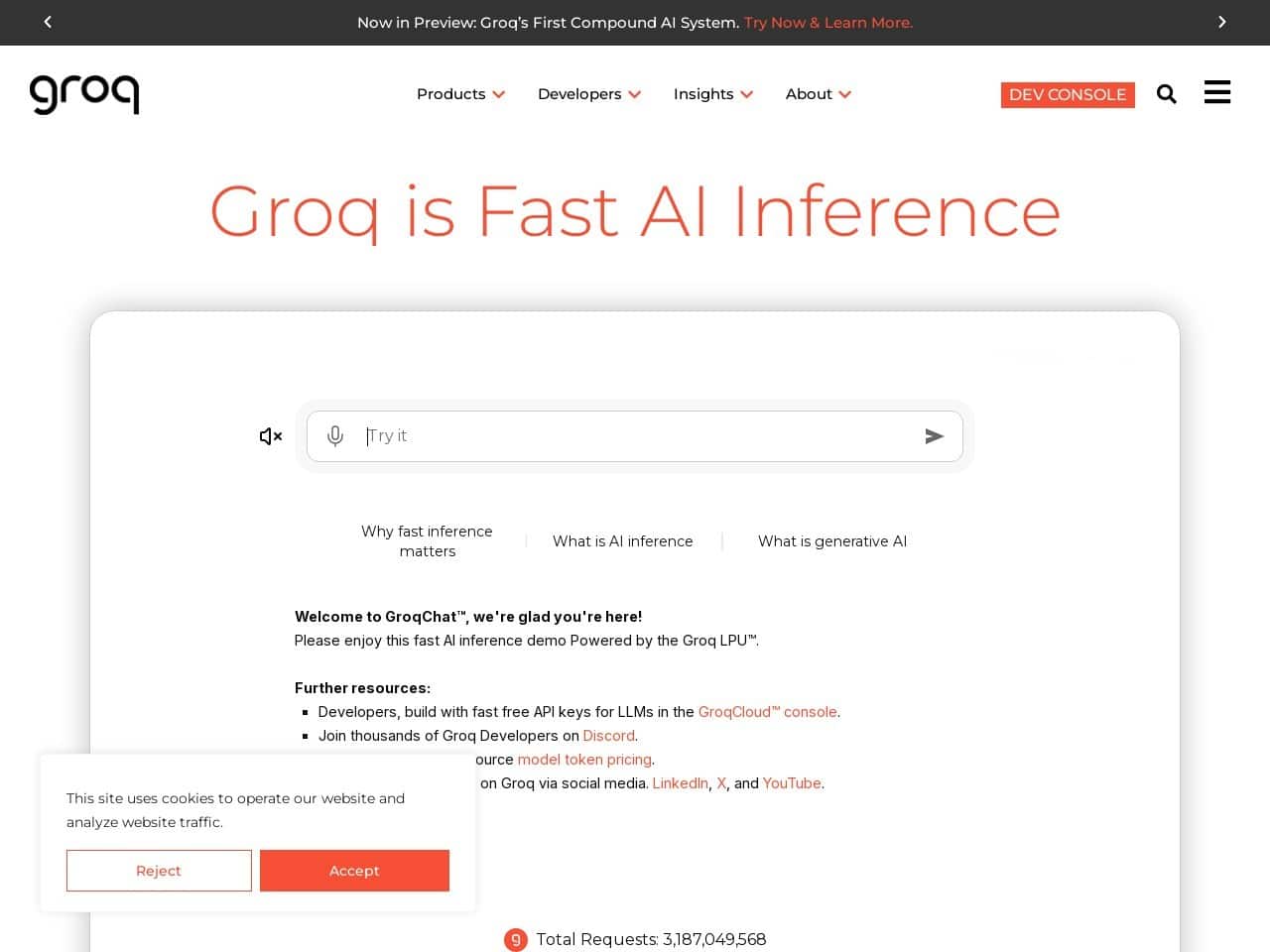

Groq凭借自研LPU架构实现AI推理速度革命,为金融、客服、工业设计等领域提供毫秒级响应解决方案,重新定义实时计算边界

所在地:

美国

语言:

英语

收录时间:

2025-05-14

颠覆AI推理的闪电侠:Groq如何用LPU改写游戏规则?

当全球科技巨头还在GPU的赛道上你追我赶时,这家硅谷新贵已悄然开辟新战场。由“TPU之父”Jonathan Ross创立的Groq,正用自研的 语言处理单元(LPU) 掀起AI推理速度革命——每秒处理700个令牌的狂暴性能,直接把传统GPU甩出十条街。

一、芯片架构:当确定性遇见超高速

Groq的LPU就像个精准的瑞士钟表匠,用确定性流式架构重构计算逻辑。抛弃传统多核设计的混沌调度,单芯片230MB SRAM构成的高速跑道,让数据无需在内存间折返跑。这波操作不仅实现5-10倍于NVIDIA H100的推理速度,更将能耗砍至对手的1/3。

| 性能指标 | Groq LPU | NVIDIA H100 |

|---|---|---|

| 令牌处理速度 | 700/秒 | 70-140/秒 |

| 硬件成本/Tokens | $0.27/百万 | $1.89/百万 |

| 典型功耗 | 200W | 700W |

数据来源:GroqCloud定价文档及第三方测试报告

二、生态布局:云+端的双重奏

Groq左手握着GroqCloud这把利剑,用$0.27/百万tokens的激进定价横扫API市场;右手为车企、金融机构等大客户定制本地化方案。这种“云服务引流,硬件变现”的打法,短短16周就圈粉28万开发者,连Meta的Llama3都跑来站台。

杀手级应用场景:

- 金融领域的StockBot:基于Llama3 70B模型,秒级生成带交互图表的投资分析

- 客服系统:aiXplain部署的实时对话引擎,客户等待时间从分钟级压缩至毫秒

- 工业设计:Sourcetable电子表格通过LPU加速,复杂公式运算提速8倍

三、硬核技术背后的冷思考

尽管LPU在单序列推理场景独孤求败,但面对长上下文处理仍显吃力。更棘手的是,其完全定制化的架构就像把双刃剑——14nm制程虽降低成本,却需专用编译器才能发挥威力。有分析师算过笔账:想要盈亏平衡,Groq得把现有速度再提7倍!

“Not only does Groq deliver speed, but it also slashes energy consumption,” 某AI实验室负责人感叹,”But integrating it requires rewriting half our codebase.”

四、未来战场:推理芯片的三大博弈点

- 成本效益比:LPU的每token成本虽低,但前期投入是H100服务器的40倍

- 开发生态:vLLM等开源框架的适配进度,决定中小企业的采用意愿

- 场景渗透:自动驾驶需要的实时决策,可能比ChatBot更考验架构极限

正如半导体教父吉姆·凯勒预言:“未来五年,AI芯片将分化成训练巨兽和推理飞刀。”Groq显然押注后者,但想从NVIDIA碗里抢肉吃,光靠速度还不够——得把开发者生态建成护城河。

相关导航

一家全球领先的CRM公司,AI技术能力也强

C3.ai

C3.ai凭借模型驱动的AI开发平台,为全球500强企业提供垂直行业智能化解决方案,在能源、国防、医疗等领域树立数字化转型标杆

AMD

AMD凭借创新架构与高性价比策略,持续颠覆处理器与显卡市场格局,2025年以Zen4/RDNA3技术领跑半导体行业革新浪潮

阿里达摩院

揭秘阿里达摩院如何用AI改写未来法则,从癌症早筛到量子革命,硬核科技重塑人类生活!

Amazon AI

AWS提供全面的AI和ML服务,助力各类组织实现业务转型和创新

Anthropic

Claude模型的母公司

Kyutai

法国的一家AI技术发展的非盈利研究机构

Nvidia

NVIDIA 发明了 GPU,并推动了 AI、HPC、游戏、创意设计、自动驾驶汽车和机器人开发领域的进步。

暂无评论...