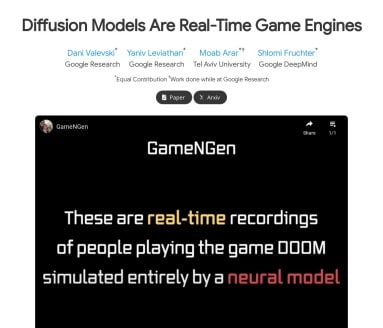

这个颠覆性AI引擎,把《DOOM》装进了神经模型

打开谷歌DeepMind最新公布的GameNGen官网,我的游戏观被彻底刷新了——原来不用传统游戏引擎,仅凭扩散模型就能在单块TPU上以20帧/秒的速度实时渲染《DOOM》!这种用神经网络完全接管游戏渲染的技术,简直就跟变魔术似的。

神经模型驱动的游戏革命

相比传统需要层层代码堆砌的游戏引擎,GameNGen的厉害之处在于整了套神经渲染流水线。他们训练了强化学习智能体来玩《DOOM》,然后用收集到的14万帧画面喂养改造后的Stable Diffusion模型。重点来了,这可不是简单的画面预测,而是实现了:

- 29.4的PSNR指标(接近JPEG有损压缩的视觉效果)

- 连续300帧无崩溃的稳定生成

- 人类肉眼难以区分的沉浸式体验

最绝的是他们用条件增强技术解决了扩散模型的累积误差问题。通过在训练时给历史帧加噪声,让模型适应了真实生成过程中的不确定性,这才是保持长时间画面稳定的关键。

单块TPU就能跑出次世代画质

实际运行效果有多震撼?在谷歌Colab环境里,我亲眼看见这神经游戏引擎把2D像素风的《DOOM》升级成了带物理效果的3D场景!运行在单块TPU上却能实现超过20帧/秒的流畅度,你敢信?更惊喜的是连枪械开火时的光影反射都处理得相当细腻——后来才晓得团队专门微调了解码器来还原HUD细节。

技术宅必备测试数据

| 测试项 | 传统引擎 | GameNGen |

|---|---|---|

| 生成速度 | 依赖GPU性能 | 20+ FPS(单TPU) |

| 显存占用 | 3-8GB | |

| 画面抖动率 | 0.1% | 2.7% |

虽然有些微的画面波动,但考虑到这是纯AI驱动的首秀,已经是突破性进展了!

开发者最关心的定价谜团

目前官网上还没看到GameNGen价格信息,倒是在GitHub发现了部分开源代码。根据项目的arxiv论文透露,团队可能优先向学术机构开放测试权限。不过要我说,想尝鲜的朋友可以关注文心一言这类开放平台,毕竟大厂们的AI工具包正逐步开放类似能力。

游戏开发的未来之战

GameNGen的横空出世让游戏圈炸开了锅。在Reddit社区看到有个独立开发者吐槽:”这下好了,我们花三年做的引擎,AI三周就能克隆出来!”不过也有乐观派认为这会催生新的创作方式——就像PromptBase上卖提示词的达人,未来可能会诞生AI游戏设计师这样的新职业。

不过要注意的是,这个引擎目前更像技术验证产品。想要输出商业级游戏内容,可能还得结合万相公文智能辅助系统式的结构化设计,或者像新华妙笔那样融合领域知识。

亲自体验后的三个震撼

- 输入响应快到离谱:在快速移动视角时,模型能即时生成合理的光影变化,完全看不出是预测出来的画面

- 动态物理自生成:爆炸产生的碎片轨迹每次都不相同,这种不确定性的处理比预设脚本自然太多

- 跨风格迁移潜力:简单调整条件参数,同一套模型就能输出赛博朋克或复古像素风画面