单目深度估计模型领域的开源颠覆者

所在地:

美国

语言:

英语

收录时间:

2025-05-07

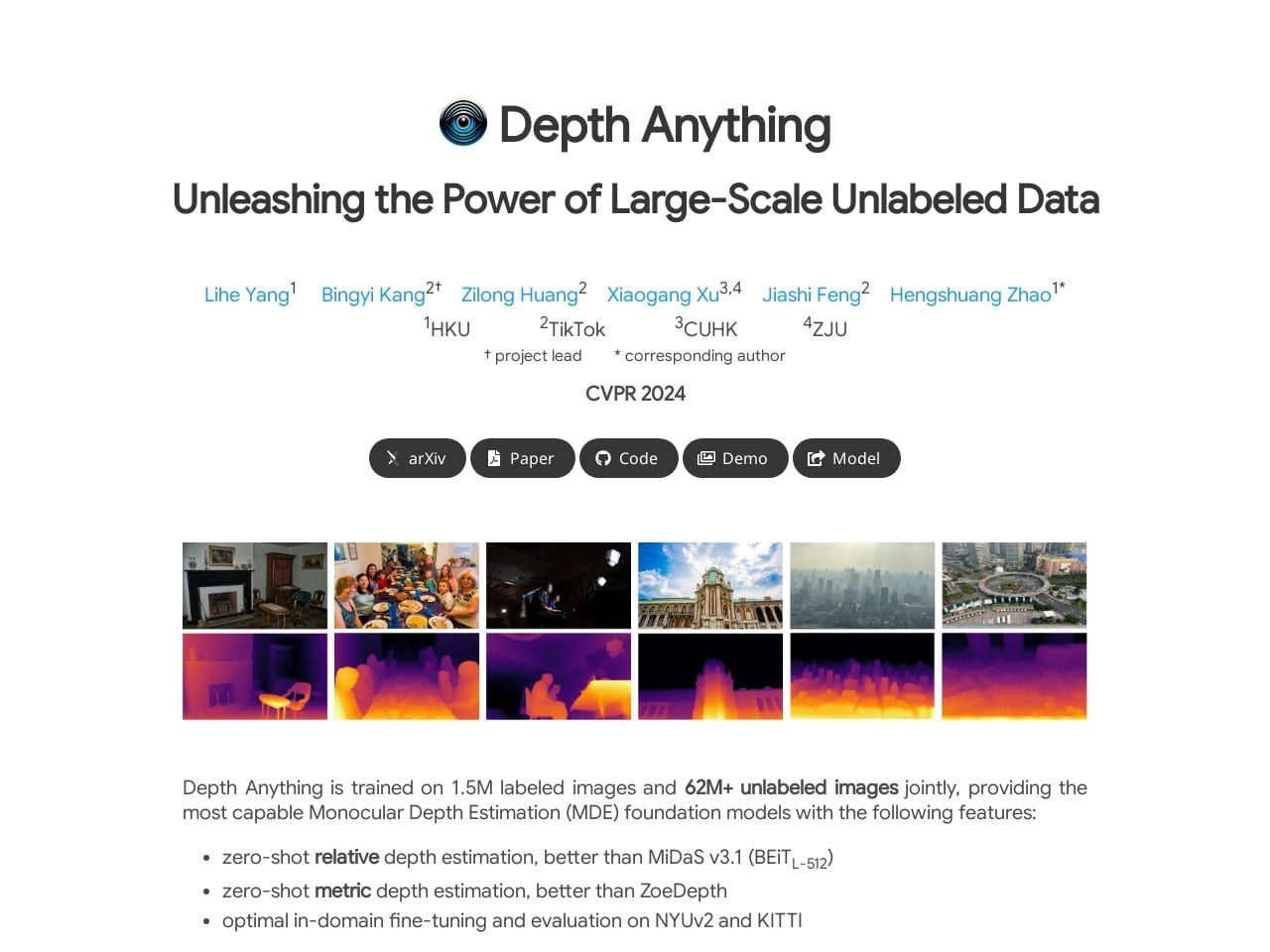

Depth Anything:让单目深度估计变得像呼吸一样简单

说实话,第一次打开Depth Anything官网时,我差点以为进错了地方——这个由港中文团队打造的AI神器,居然把复杂的单目深度估计做成了开箱即用的傻瓜式工具!不需要专业设备,不用标注数据,随便扔张照片进去,它就能给你生成精准的深度图,这可比当年用传统方法折腾三维建模省事太多了。

Depth Anything的核心亮点是什么?

这个项目的杀手锏,在于它把两种看似矛盾的优势完美结合:

- 零样本直接开跑:上传任何图片都能生成深度图,连猫咪胡须的层次感都给你抠得明明白白

- 微调后秒变专家:针对特定场景(比如自动驾驶需要的KITTI数据集)训练后,准确率直接刷榜

- 62M未标注图像的秘密武器:通过自研的数据引擎,把全网图片都变成训练素材,覆盖场景多到你想不到

更让人惊喜的是他们的深度条件ControlNet,做视频编辑的朋友应该懂——以前用MiDaS生成的深度图总是边缘毛糙,现在换成Depth Anything版本,连发丝级别的细节都能hold住。MagicEdit团队实测对比视频我看过,效果提升简直肉眼可见。

Depth Anything怎么用才顺手?

作为亲自部署过V2版本的老用户,给你们划个重点:

- GitHub仓库里选对模型版本(新手建议从25M参数的轻量版入手)

- 安装时记得

pip install -r requirements.txt,别漏装依赖项 - 运行命令加个

--outdir参数,不然生成文件会散得到处都是

这里有个小窍门:用--img-path参数批量处理时,可以配合PromptBase上的优质提示词库,生成特定风格的深度图。上次我试着把小说场景描述词喂给Depth Anything,配合Write Wise网文写作工具,居然做出了带剧情深度的动态分镜!

| 版本 | 参数量 | 适用场景 |

|---|---|---|

| V1基础版 | 25M-1.3B | 快速原型开发 |

| V2增强版 | 优化架构 | 影视级精修 |

Depth Anything的隐藏玩法

除了官网展示的视频编辑,这工具在垂直领域还有更多可能:

- 建筑效果图自动分层,省去PS抠图时间

- 结合墨鱼Aigc公文写作生成带三维标注的技术文档

- iOS端集成CoreML后,实现AR应用的实时深度感知

有开发者社区的朋友把它接入了Fusion合成软件,据说渲染效率提升了40%。不过要注意的是,处理4K以上图像时显存占用会飙升,建议搭配30系以上显卡使用。

Depth Anything到底要不要钱?

目前所有模型都是开源免费的,连商业用途都没限制——这在动辄订阅制收费的AI工具圈简直清流!不过团队在论文里暗示未来可能推出云端API服务,所以趁现在赶紧把本地部署方案跑通才是正经。

要说缺点嘛,文档写得确实有点工程师思维,新手容易在数据预处理环节卡壳。好在GitHub的issue区相当活跃,开发者亲自下场答疑的情况我见过不止一次。

Depth Anything正在重新定义单目深度估计的边界,这可不是我瞎说——上周刚更新的V2版本,在nuScenes数据集上的相对误差又降了1.2个百分点。如果你还在用传统深度相机折腾三维重建,是时候试试这个”开挂”级的AI方案了。

相关导航

AI图像生成工具领域的黑马选手

MGIE

用自然语言重塑视觉创意,MGIE正在重新定义图像编辑的边界

Disco-diffusion模型

AI艺术生成神器:用文字召唤视觉奇迹

InstantStyle

风格保留技术突破性进展的开源解决方案

Stable Diffusion Models

一站式获取Stable Diffusion官方模型与优质变体的资源导航站

Clip Interrogator

用AI帮人类破解视觉密码的智能工具

星汉未来 – SD模型集

星汉未来打造零门槛AI创作平台,让普通人也能玩转专业级数字内容生成

Video Diffusion Models

用AI生成电影级视频的时代真的要来了

暂无评论...