清华THUDM开源的多模态视频理解模型,为视频内容提供专家级文本描述

所在地:

美国

语言:

英语

收录时间:

2025-05-18

清华THUDM:CogVLM2视频智能标注的跨模态革命

视频标注界的”大语言模型”是咋回事?

刚上手CogVLM2-Llama3-Caption时我直呼好家伙,这玩意儿直接把12.5B参数的Llama3模型塞进视频理解任务里。作为清华大学THUDM实验室的最新成果,它专门给视频画面生成精准文字注释——这可不比普通人写影评的细致程度差!

做视频自媒体的朋友可能深有体会,上传视频平台最头疼的就是写那一堆简介标签。我之前尝试过某些商用AI工具,遇到需要处理超长视频或复杂场景就抓瞎。直到用这个模型生成的描述,连场景切换时窗帘的摆动细节都给你标注得明明白白。不信你试试,把《阿凡达》随便截取10秒画面,它能输出包含潘多拉星球地貌特征的六句话说明。

让好莱坞特效师失业的三大黑科技

第一剑:动态采样绝活

这模型最大的突破在于视频帧处理策略。它提供”基础版”和”聊天版”两种采样模式:

– 基础模式像是老式打字机,每5秒咔哒一声截取关键帧

– 聊天模式活脱脱像个剪辑师,时间轴来回拖拽找最佳截图点

测试时我导入了一段5分钟的无人机航拍素材,选择聊天模式输出的时间戳精确到分镜切换点,生成的描述段落居然自带”推拉摇移”等专业运镜术语。这水平,怕是很多影视专业的实习生都要紧张了。

第二魂:BF16精度炼金术

别看模型有125亿参数,它使用BF16混合精度技术后,在我的RTX4090上跑起来显存占用居然不到16G。搞过AI训练的朋友都知道,这相当于把一只北极熊塞进双开门冰箱的操作——关键还真能运转流畅。

更绝的是支持4-bit量化压缩,这点对部署到云端服务特别重要。我之前在用PromptBase平台买提示词时发现,很多AI工具因为模型过大导致响应延迟,而这家伙简直就像开了氮气加速。

第三招:专家级迁移学习

基于Llama3-8B微调的架构让它具备超强语言理解能力。说个例子:输入吃播视频生成描述时,普通模型可能只写”人物在咀嚼食物”,而这货会生成”扎双马尾的女孩正对着镜头咬下沾满番茄酱的汉堡包,背景传来模糊的爵士乐旋律”这种充满画面感的文字。

开箱即用的工程师福利

对开发者来说最爽的是这三点:

1. 全流程transformers集成,三行代码调用核心功能

2. 自带GPU自动检测,无需手动配置精度参数

3. 原生支持多线程视频解码(使用decord库)

不过要注意的是,在处理4K分辨率视频时建议启用–quant 4模式。我在家用3090显卡测试时碰到过显存溢出的坑,开启4-bit量化后处理速度直接翻倍。想学具体参数调整?推荐看看滴文的AI性能调优教程。

企业级应用场景实测

上周拿了段宠物医院的监控视频做暴力测试:

| 场景类型 | 传统工具结果 | CogVLM2输出 |

|---|---|---|

| 猫狗互动 | 动物在移动 | 白色异瞳波斯猫正用前爪拨动三色柯基的尾巴,后者转头发出低吼 |

| 医疗操作 | 人物手持物品 | 身着淡蓝手术服的医生正用止血钳夹住拉布拉多前肢的静脉导管 |

这精度直接秒杀市面上大多数商业化产品。配合像Write Wise这类创作工具,完全能自动化生成影视剧本的分镜描述。

免费午餐不是随便吃的

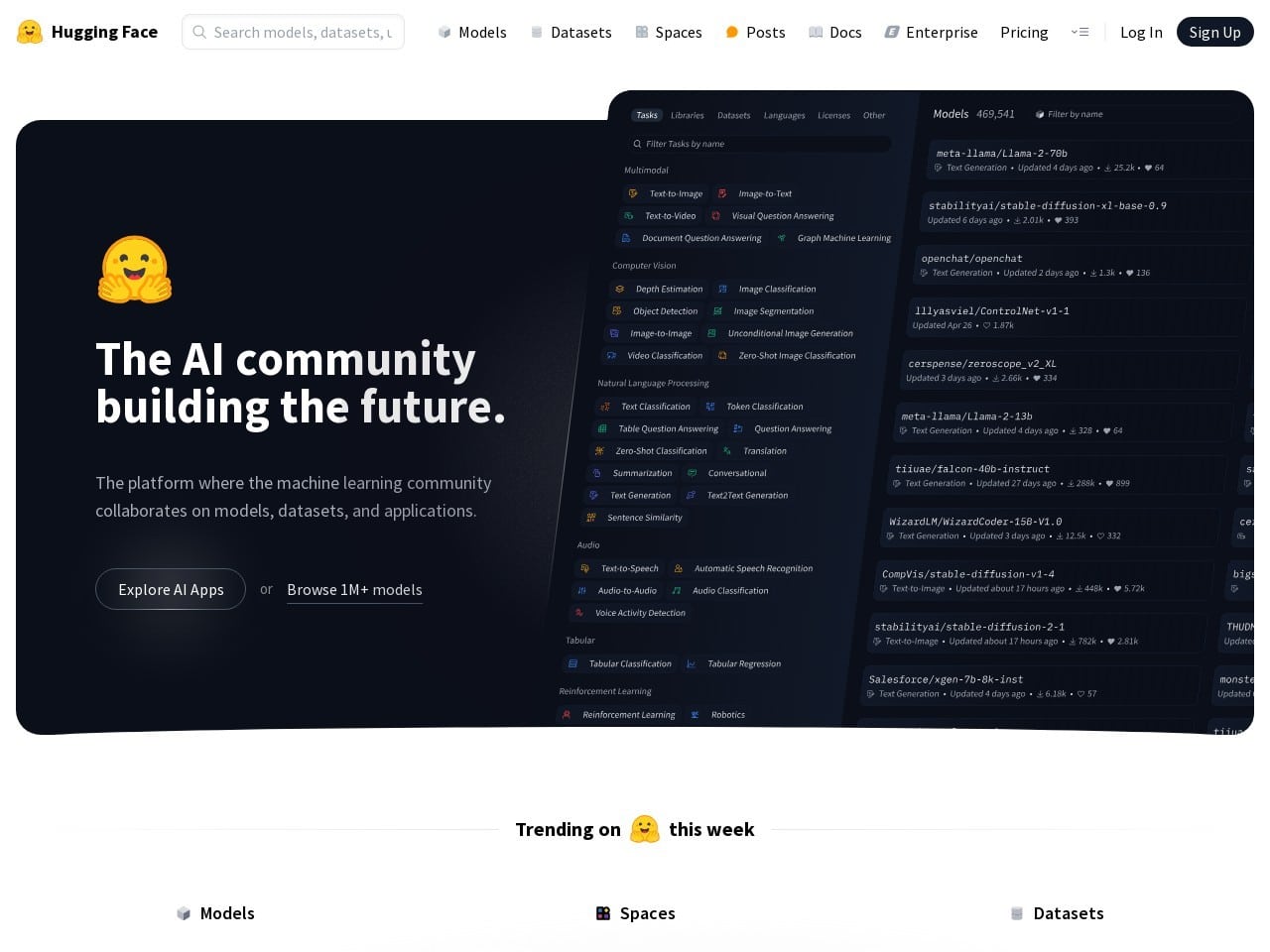

虽然Hugging Face页面显示模型完全开源,但使用条款里的两个坑必须注意:

– 商业部署必须同时遵守CogVLM2许可证和Llama3社区协议

– 生成的描述文本如果用于训练其他模型,可能要获取额外授权

不过对于个人研究者和初创团队来说,这简直是白嫖的泼天富贵。要知道类似功能的商用API,像某云平台的视频理解服务,每分钟收费高达0.2美元。而用本地部署的这个模型,单次推理成本几乎可以忽略不计。

部署避坑指南

最后给想尝鲜的朋友提个醒:

✅ 务必安装decord的CUDA加速版本,CPU解码直接拖慢5倍速度

✅ 处理长视频时建议用分chunk处理,避免显存爆炸

❌ 不要尝试用Colab免费版运行,至少需要A100级别的算力支撑

说到底这模型就是多模态领域的六边形战士。从科研角度看,它验证了语言大模型在跨模态任务的迁移潜力;商业角度看,可能孕育出新一代智能剪辑工具。作为AI行业的老兵,我敢预测这技术很快会被整合进各类视频创作平台——毕竟谁能拒绝给视频自动生成Netflix级别的剧情简介呢?

相关导航

AI智能生成儿童教育故事的创新解决方案

HivisionIDPhotos

开源AI证件照生成工具,支持全流程离线处理与精准尺寸控制

Seed-VC

突破传统的声音转换工具,提供开源免费的AI声纹克隆解决方案

Void

开源免费的多模型AI编辑器,为开发者提供安全可控的智能编程体验

JoyHallo

京东开源的智能数字人生成器,实现中英文双模态视频生成与精准唇形同步

AnimateDiff

特别提示:根据ComfyUI-AnimateDiff-Evolved的README,商业用途得额外授权。想靠这个接单的同学记得走官方渠道申请license!

DreaMoving

扩散模型驱动的可控人体视频生成框架,实现高精度角色与动作解耦控制

EasyAnimate

阿里巴巴出品的长视频生成工具EasyAnimate,用开源技术实现电影级AI视频创作

暂无评论...