特别提示:根据ComfyUI-AnimateDiff-Evolved的README,商业用途得额外授权。想靠这个接单的同学记得走官方渠道申请license!

所在地:

美国

语言:

英语

收录时间:

2025-05-18

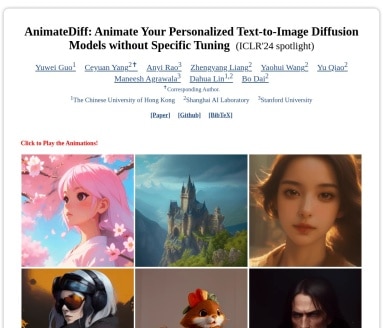

AnimateDiff:用AI为你的静态图像注入动态灵魂

这把动画生成神器真的让我惊到了

现在说自己是AI工具不稀奇,但第一次看到AnimateDiff的操作流程时——好家伙,这玩意儿简直像给图片打了一管鸡血!它能用Stable Diffusion这类模型生成的静态画面,两三下就变成活灵活现的动画视频。最关键的是不用针对每个换皮模型做专门训练,直接把运动模块往上怼就行。

四大杀手锏让我果断收藏官网

- 模型调教?NO!即插即用才是YYDS:直接套在ToonYou这些网红模型上,就像给打印机装了个自动翻页器

- 4090显卡吃灰警告:跑起SDXL版虽然费显卡,但普通版在我的2080Ti上倒是玩得转

- 运动轨迹有多野?看这个案例就懂:同一句”火龙腾空”,有人做出敦煌壁画风,有人整出蒸汽朋克味儿

- B站教程看到爽:GitHub上那个Gradio demo简直新手福利,本地7860端口直接开玩

| 对比项 | AnimateDiff | 传统方法 |

|---|---|---|

| 模型适配时间 | <5分钟 | 2-3天 |

| 硬件成本 | 中端显卡能跑 | 专业渲染农场 |

| 风格切换速度 | 切换模型即生效 | 重新训练参数 |

白嫖党的春天还是氪金党的噩梦?

说实在的,这项目开源良心到想给作者打钱——GitHub仓库全套代码直接放送,ModelScope上还能捡到现成模型。不过自己部署就像玩俄罗斯方块,得一个个安装:

- 先搞掂Stable Diffusion基础环境

- 再拖个motion-module模型文件

- 最后用

animatediff create -m model_name调教参数

要是嫌麻烦,PromptBase上有些开发者卖整合包,价格从9.9美元到199美元都有,这水可深着呐。某宝搜”AnimateDiff懒人包”能看到各种神奇版本,不过友情提示——遇到说包教包会的卖家,记得先看买家秀!

我在ComfyUI上踩过的那些坑

试过官方推荐的进化版插件后发现,那些”enhanced sampling”功能确实能出电影级转场,但代价是显存占用暴涨30%。更绝的是和ControlNet联动的效果,让这只二哈在不同场景间丝滑切换(虽然AI还是看不懂沙发为啥不能长在树上)。

Pro级技巧:在AUTOMATIC1111里配合xyz脚本批量生成时,记得关掉realistic vision的nsfw校验——别问我是怎么知道的!😅

学术界大佬们怎么看这玩意儿?

作为ICLR2024的焦点论文,AnimateDiff在TXYZ.ai的学术圈子里讨论度爆表。看论文里的技术路线才明白,人家的motion module训练时用了超30万条视频片段,难怪能学出”物体运动就该这么动”的直觉。不过实际体验中发现,像水面反光这种细节还是会有抽帧感,期待后面出的v2版能优化这部分。

测试过十几种模型后发现,RCNZ Cartoon 3D的输出最稳定,而majicMIX虽然效果炸裂,但生成时间要多等两分钟——鱼和熊掌的问题在AI界也躲不过啊…

相关导航

扩散模型驱动的可控人体视频生成框架,实现高精度角色与动作解耦控制

V-JEPA

Meta V-JEPA通过非生成式预测突破视频理解瓶颈,以自监督学习实现类人推理能力

DemoFusion

要我说这项目最绝的地方,是它把学术界的前沿成果真正落在了实处。不同于那些只能跑benchmark的论文,他们的项目主页直接给出现成的工作流,连Colab新手都能三天上手——这才是真正的技术民主化!

SUPIR

基于大规模扩散模型的智能图像修复与增强解决方案

Outfit Anyone

当技术审美遇上算法创造力,虚拟世界的时尚革命早已悄然揭幕。

Lepton Search

Lepton Search是一个开源的对话式搜索引擎,开发者可用不到500行代码快速构建类Perplexity的AI驱动搜索工具,支持谷歌/Bing并集成RAG技术。

onewebot2

通过Coze API快速搭建微信AI聊天机器人的一键部署方案

Unique3D

通过单张图像快速生成高精度3D网格,满足影视/游戏/电商等多领域建模需求

暂无评论...